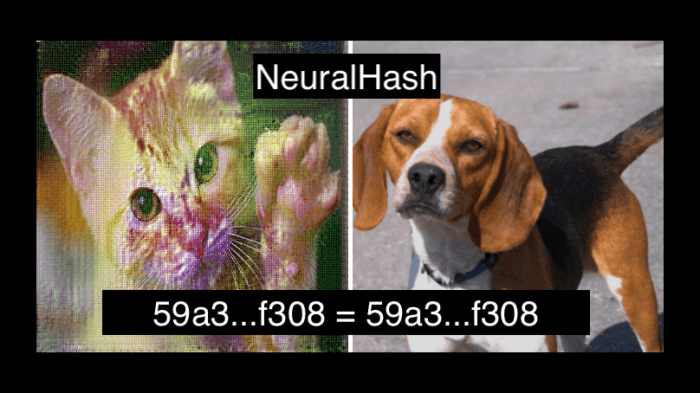

Néhány hete röppent fel a hír, hogy az Apple egy olyan funkciót fog az iOS 15-be építeni az amerikai piacon az iCloud Fotók esetén, ami képes gyermekpornográfiának (CSAM, azaz Child Sexual Abuse Material) minősülő képek automatikus keresésére és jelentésére a készüléken. A lépést világszerte kritizálták mind technológiai, mind etikai szempontból.

Korábbi cikkünkben már írtunk arról, hogy pontosan hogyan is működik ez a rendszer, és ennek megfelelően milyen információbiztonsági felvetések jogosak vagy éppen alaptalanok a CSAM technológiai megoldásával szemben. A lelkes informatikusok persze már rövid idővel az ezzel kapcsolatos hírek elterjedése után elkezdtek próbálkozni a rendszer visszafejtésével és a műszaki részletek tanulmányozásával.

(tovább…)

Ezek még érdekelhetnek:

Ez a cikk Átverhető-e az Apple NeuralHash-alapú CSAM felismerője? itt jelent meg először Szifon.com.